- Column

- AI活用に取り組む企業のためのプラットフォーム

AIプロジェクトの落とし穴の1つはAIのためのインフラにあり【条件1】

AIインフラを特異視することがサイロ化を招く

このようなAIインフラ特有の傾向から、AIインフラは従来的な社内システムのためのITインフラからは区別され、特殊で難易度が高いインフラと見なされがちだ。AIインフラが既存のITインフラに統合されることはあまりなく、ほとんどはAIインフラのみが独立した形で導入・運用される。つまりAIインフラはサイロ化された状態になり易く、そのため他部門とリソースの共用がしづらいというデメリットがある。

企業によっては、上述したAIインフラと従来システムの大きな違いから、IT部門のスタンダードに合わないとして、IT部門の管轄外とする企業も少なからず存在する。

その場合、AIインフラの導入・運用は非IT部門であるAI開発部門やAIユーザー部門が担う場合が多いようだ。筆者は、担当者自らがワークステーションやサーバーアプライアンスを直接メーカーから購入し、自分のデスクの下に設置して使っているケースを複数、知っている。

こうした状況は、いわゆる「シャドーIT(管理されていないIT)」的な状況に陥り易い。ガバナンスやセキュリティー上の潜在的なリスクだけでなく、貴重なAI開発人材のリソースが、本来のミッションとは関係のないインフラ導入・管理に取られてしまうというデメリットがある。企業にとっても“あるべき姿”とは言えないであろう。

パフォーマンスを追及するが故のベアメタルでの運用もトレードオフを伴う。ベアメタルで運用されているAIインフラは、仮想化されたITインフラのように、可用性や管理性、セキュリティーを実現する術がない。仮想化されていないため、他部門とリソースを柔軟に共有する仕組みに欠けていると言える。

IT部門が運用しやすい統合インフラを目指す

ではAIインフラは、どのように構築・運用していくべきであろうか。もちろん理想的なAIのための環境は、企業の戦略や規模、AIシステムの用途、投資体力、など多数の要素によって変わり得る。今回は、「複数のAIシステムの用途を持つ中規模以上の企業」を想定し、同社のためのAIインフラを考えてみる。

まず直近では、AIシステムの用途の多様化とインフラへの投資効率の向上を目的にすえ、複数部門が複数の用途に共有的に使用できる統合インフラの構築を目指すことが、実現性から考えても良いステップだと思われる。

その場合の統合インフラは仮想化する必要がある。仮想化によって従来のベアメタル型AIインフラに起こりがちだったサイロ化を解消し、インフラの使用効率を改善する。仮想化ソフトウェアの機能を活用することは可用性や運用管理性の改善にもつながり、AIインフラの主要なデメリットの多くが克服できる。

こうしたAIインフラの統合化は、日本でも先進的な企業は既に取り組んでいる。必要なAIリソースを、必要なタイミングで、必要なだけユーザー部門に割り振りたいからだ。この場合の課題は、前述のパフォーマンスである。仮想化した際には、仮想化に取られるオーバーヘッドを最小化するための工夫とノウハウは別途、必要である。

その場合のAIインフラの導入・運用の主体は、やはりIT部門であるべきだろう。企業の体制としてAIシステムの開発・ユーザー部門が、しっかりとしたインフラの管理体制を敷けるのであればもちろん問題はない。だが一般的には、そこまでのIT人員を割けない企業が多いことだろう。

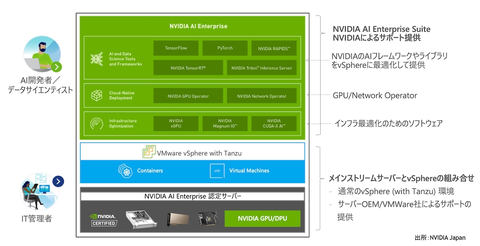

上記のような環境の実現手段は複数あり得る。ITベンダーの側でも、AIインフラを構築するための製品群やサービスの構築に動いている。筆者が所属する米NVIDIAの例でいえば、「NVIDIA AI Enterprise」がそれに該当する(図2)。

NVIDIA AI Enterpriseは、仮想化環境を提供する米VMwareと共同開発した。VMwareの「VMware vSphere」は従来型のITインフラでは多用されており、IT部門は使い慣れた環境として運用できるからだ。

IT部門が必要なだけのAIインフラリソースをAI開発者に割り振れる。AI開発者は、割り当てられたリソースを使って、NVIDIA製GPU(Graphics Processing Unit)に対応した「PyTorch」や「TensorFlow」といったAIフレームワークやSDK(ソフトウェア開発キット)を利用すればよい。

この環境では、vSphereによる仮想化に対応したうえで、そのパフォーマンスはベアメタル相当を担保している。NVIDIAが提供するソフトウェアにはエンタープライズレベルのサポートも提供する。上述したAIインフラの課題は、ほぼ克服できているといえる。

なおNVIDIA AI Enterpriseを簡単に試せる仕組みとして「NVIDIA LaunchPad」を米Equinixとの協業で準備している。興味がある方は是非、NVIDIAのWebサイトから申し込みトライしていただきたい。

AIインフラが目指すべき姿は、長期的には、AIインフラがエンタープライズインフラに統合され、1つの大きなコンピューティングリソースの一部として運用されることだろう。ただ長期的にと言っても、昨今のAI界隈の長足の進歩を考えれば、それほど遠い未来ではないのかも知れない。

川井 源(かわい・げん)

エヌビディア データセンターGPU営業推進シニアマネージャー。インテルで約10年、営業・マーケティングを経験した後、デル・テクノロジーズでエンタープライズ向けの営業職に従事。2021年から現職。中央大学でMBAを取得。