- Column

- AI活用に取り組む企業のためのプラットフォーム

AIプロジェクトの落とし穴の1つはAIのためのインフラにあり【条件1】

AI(人工知能)システムの市場規模について、市場は国内外を含め急成長しており、今後についても長期的な右肩上がりが続くと様々な調査が予測している。一方で、AI関連プロジェクトの多くがPoC(概念実証)段階から本番稼働に行き着けずに消滅しているという現状もある。その背景には、従来のITインフラとAIシステムを開発・実装するためのITインフラ(本稿では「AIインフラ」と呼ぶ)の違いがある。その差を理解することがAI技術の活用に取り組む企業には必要だ。

昨今の新型コロナウイルス感染症(COVID-19)の影響で企業のデジタルトランスフォーメーション(DX)への取り組みは大きく加速した。その中でAI(人工知能)関連プロジェクトへの投資意向や投資金額は増加し、AIシステムの大規模化と用途の多様化・細分化の傾向も顕著だ。既に多くの業界において、AI技術は特別なものではなく、競争に勝ち抜くうえでの必須要素だとみられている。

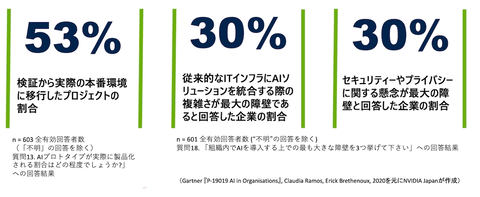

その一方で、企業がAI技術を自社ビジネスに実装するに当たり、AI関連プロジェクトの多くがPoC(概念実証)でつまずき、本番稼働に行き着けず消滅しているという現実もある。米調査会社ガートナーの調査によれば、世界で約半数の企業がPoCから本番環境への移行に失敗し頓挫している(図1)。

同調査では、AI関連プロジェクトの最大の障壁として全回答者の30%が「従来型のITインフラにAIソリューションを統合する際の複雑さ」だと考えている。ITインフラがAI関連プロジェクトの成功を左右する重要な要素の1つであることが示唆されている。なお本稿では、ハードウェアだけでなく、アプリケーションより下層のミドルウェアレイヤーも含めた環境を「ITインフラ」と呼ぶ。

進歩が速いAI技術が求めるAIインフラの特異性

企業のITインフラは過渡期にある。多くの企業が「2025年の崖」を克服すべく、レガシーシステムからの脱却とITインフラの近代化を目的に、既存インフラの整理・最適化・再配置に取り組んでいる。

そのトレンドの中でAI関連プロジェクトが並行して進んでいる。その際、AIシステムを開発・実装するためのITインフラ、つまり「AIインフラ」は、従来の業務システム向けITインフラとは明確に区別され“特殊な環境”として扱われることが多い。

確かに、従来的なITインフラとAIインフラの間にはいくつかの相違点がある。主にはAI技術が開発途上にあり、その進歩が非常に速いことによるものだ。

AI分野は現在、世界中の大学・企業などが取り組む研究対象である。盛んな研究開発の成果として、最新のアルゴリズムとコードで書かれたソフトウェアが日々、リリースされている。AI開発者は、それら最新のアルゴリズムとコードで書かれた、多くの場合はOSS(オープンソースソフトウェア)であるコンポーネントを組み合せてシステムを構築する必要がある。

日々リリースされるコンポーネントを組み合わせてのシステム導入・開発は、従来的なITシステムの導入・開発と比較すると、知見とノウハウが整理・蓄積されていない状態でシステムを検討することとなり、難易度とリスクが高い。

最新のソフトウェアコンポーネントは、そのアップデートのペースも早く、かつ個別バラバラに進化する。そのため、更新時に不整合が生じる状況になりがちだ。よって導入時のみならず、運用においても難易度とリスクが高いシステムになり易い。

この様な特異性から、システムの拡張時にも問題が起き易い。冒頭に触れたPoCから本番への移行は典型的なAIインフラの拡張例であるが、その成功率が高くない理由の1つは、上述したAIインフラ特有の拡張の難しさによるものであろう。

拡張の難しさは、ビジネス上の機会損失が発生する事態も起こし得る。本番移行後にAIシステムの大規模化が進んでいるにもかかわらず、そのインフラ拡張を、求められたタイミングに実施できなければ、本来であればAIシステムを前提としたビジネスを実施できなくなるからだ。

保守の観点でも難しさがある。AIシステムの構築には無償のOSSを使用するケースが多いと述べた。だがOSSではIT部門が求めるレベルの保守が提供されないのが一般的だ。保守が受けられないことは、IT部門の目線では大きなリスクであり、IT部門や利用部門はOSSの導入や管理に頭を悩ませることも多い。実際のところ商用ディストリビューションがないOSSは基本的には採用しないと決めている企業・IT部門も少なからず存在する。

別の切り口として、特にAIシステムの学習用途においてAIインフラに求められるパフォーマンスが高い点も一般的な業務システムにはない特徴だ。AI開発者は、AIインフラのパフォーマンスが開発効率を大きく左右することを経験的に知っており、インフラ選定に際しパフォーマンスにこだわる場合が多い。AI技術者やデータサイエンティストという貴重な人的リソースから得られる成果を最大化したいためだ。

結果、AIインフラはベアメタルとして実装されがちである。ベアメタルを選ぶ理由は、もちろんパフォーマンスの最大化にある。ソフトウェアのレイヤーを極力少なく抑えることでシステム上のオーバーヘッドを低減しようとの考えからだ。