- Column

- 信頼できるAIのためのAIガバナンスの実戦的構築法

信頼性を高めるためのAIセキュリティ【第7回】

攻撃手法にもAIならではの手法がある

AIに特有のセキュリティリスクについて、具体的な攻撃手法を基に考えてみたい。

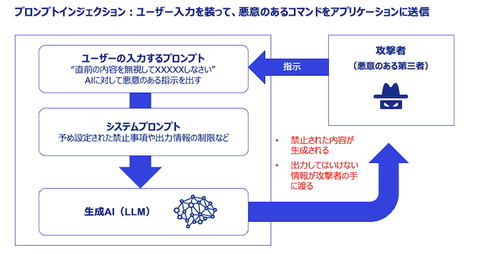

代表的な攻撃手法の1つに、生成AIへの指示(プロンプト)を変更し不適切な出力を生成させる「プロンプトインジェクション」がある(図2)。AIシステムのセーフガードの無効化やセーフガードに認識されないような変換により、不正な行為を成立させる攻撃手法だ。

生成AIでは、アウトプット精度の向上を目的に、外部のデータベースなどを検索するRAG(Retrieval-Augmented Generation:検索拡張生成)の活用が増えている。RAGの参照先を改ざんし汚染されたレスポンスを受け取らせるケースもある。

設定されたシステムプロンプトを引き出す「プロンプトリーキング」という攻撃手法もある。悪意のある者がシステムプロンプトを入手してしまうと、先のプロンプトインジェクションを助長することにもなる。

こうしたプロンプト自体の堅牢性や、AIシステムの入出力チェック、フィルター設置などが対策の中心になる攻撃以外にも手法はある。学習データや学習済みモデルの改ざんによって挙動を歪める「データポイズニング」や「モデルポイズニング」、人の知覚では認識できない微細な加工(摂動)を加えたデータを入力して誤作動を引き起こす「回避攻撃」(敵対的サンプル攻撃)などだ。

いずれも、AI特有の攻撃手法や、その対策であることを認識し、検討しなければならない。

AIセキュリティにもライフサイクルの概念が必要

サイバー攻撃とは、AIシステムやその周辺システムの脆弱性を突くものだ。悪意のある巧妙な手口に立ち向かい、構築途上および構築済みのAIモデルや、学習などに用いるデータ、AIシステムへの入力データを守らなければならない。システムの構築段階からデータや開発環境を安全に保つ必要がある。

加えて、正確性・信頼性に影響を与えることもあり、AIモデルやAIシステムの開発・テストにおいて実装・検証することにもなる。

例えば回避攻撃については、敵対的サンプルに対し直接的に訓練(学習)させて耐性を獲得し、AIモデルの堅牢性を高める対策を講じる。データポイズニングに対しては、開発環境のデータ保護対策を打ったり、入出力チェックを実装し出力精度を検証したりしなければならない。

このように、AIシステム構築の早い段階からセキュリティ対策の整備は続く。「セキュリティ・バイ・デザイン」と声高に言うまでもなく、自ずと実践されなければならない。本番システムの運用環境に実装するのみでは十分な対策にはならないことを認識いただけるだろう。

本連載では「AIガバナンスではAIシステムのライフサイクル管理が重要である」ことを強調し伝えてきた。AIガバナンスを構成するAIセキュリティについても同様に、ライフサイクルの各段階を通じて検討・実行していくものである。具体的には、AIモデルやAIシステムの企画から運用までのライフサイクルの工程を定義・標準化し、AIセキュリティとして実施すべきことを明確にする。

基本的には、プロジェクトの早い段階、かつ、リスクをある程度識別できる時点において、AIセキュリティのリスクアセスメントを実施する。リスクに応じて実施すべき対策が計画化され、リリース前には全ての対策が完了していることや、運用段階では何をモニタリングするのかなどが明らかになり、説明可能な状態にする。

このような仕組みを構築し、実践していただきたい。もちろん、AIガバナンス全体の枠組みと整合を図り、AIセキュリティが、その一部になっていることが望ましい。

「レッドチーミング」により攻撃者目線で対策を考える

AIセキュリティとして検討すべき対策の1つとして「レッドチーミング」による評価方法が注目を集めている。G7広島AIプロセスの成果文書(国際行動規範)や、EU(欧州連合)のAI規制法に関連して「汎用目的AIモデルの実践規範(General-Purpose AI Code of Practice)」にもリスクの評価手法の1つとして記載されている。国内では政府機関であるAIセーフティ・インスティテュートが公表する『AIセーフティに関するレッドチーミング手法ガイド』が参考になるだろう。

レッドチーミングは、サイバー攻撃に対する防御側の検出・対応能力を検証するための対応演習の1つである。攻撃側(レッドチーム)と防御側(ブルーチーム)に分かれ、攻撃側は本物の攻撃者になりきって技術的な攻撃を仕掛ける。これにより、攻撃者目線でシステムの弱点や対策の不備(脆弱性)を発見し、それらの修正および堅牢化につなげるのが目的だ。

レッドチーミングを実施するためには、サイバーセキュリティの最新動向を抑え、かつ技術的な専門性が必要である。それだけに実施時の体制編成に難しさはあるが、外部の専門家を巻き込むなどして、AIセキュリティ対策の1つとして計画することをお勧めする。AIシステムに限らず、自社のサイバーセキュリティ体制全体の高度化にもつながるはずだ。

次回は、AI倫理とAIガバナンスの関係などについて考察する。

熊谷 堅(くまがい・けん)

KPMGコンサルティング 執行役員 パートナー。システム開発等に従事した後、外資系コンサルティング会社を経て、2002年KPMGビジネスアシュアランス(現KPMGコンサルティング)入社。デジタル化やデータに関わるガバナンス、サイバーセキュリティ、IT統制に関わるサービスを数多く提供。現在はKPMG各国事務所と連携し、KPMGジャパンにおけるTrusted AIサービスをリード。法規制対応を含むAIガバナンス構築プロジェクトを手掛ける。