- Column

- 信頼できるAIのためのAIガバナンスの実戦的構築法

AIシステムのモニタリングと透明性・説明責任の確保が重要に【第5回】

前回は、AI(人工知能)ガバナンスの構築において重要なAIシステムの企画から設計、開発、展開、運用などの一連の流れを意味するAIのライフサイクルの全体像を解説した。今回は、そのAIライフサイクルの中で重要性が増している稼働後のモニタリングについて解説する。

AI(人工知能)システムの導入が急速に進む中、予期せぬ動作や不具合といったリスクへの関心が高まっている。なかでも、その重要性が注目されているのがモニタリングだ。AIシステムは一度導入して終わりではなく、データの変動や予測精度の劣化を早期に発見し対処することで、利用に伴うリスクを最小限に抑える必要があるからだ。

AIシステムはデータの変化により意図した通りに動作しなくなる

AIシステムのモニタリングとは、入力データや、処理プロセス、出力結果を継続的に確認し、異常や不正な動作を検知・対処する一連の活動を指す。入力データの品質と整合性のチェック、AIモデルの予測精度と性能の監視、出力結果の妥当性と整合性の検証などが相当する。

もちろん、一般的なITシステムであっても運用開始後のモニタリングは必要であり、AIシステムに限られるものではない。ではなぜAIシステムは、モニタリングの必要性や重要性が強調されるのだろうか。

従来のITシステムは、人が作成したルール(仕様書)通りにプログラムが構築され、想定外の処理結果には何らかのバグの存在が関係する。これに対しAIシステムでは、学習データによって推論処理に必要なパラメーターが自動的に最適化されるため、学習データが変われば出力結果も異なってくる。つまり、人が意図した通り、期待した通りの結果にはならない可能性がある。

さらにAIシステムでは、何らかの変化によってモデルの予測性能が劣化することがある。これを「ドリフト」と呼ぶ。本番環境にあるAIシステムにおいて時間経過とともに生じる現象で、大きく「概念ドリフト」と「データドリフト」に分けられる。

概念ドリフトは、AIモデルに期待される、望ましい出力の基準が時間経過とともに変化することで、以前は正しいとされた結果が適切ではなくなってしまう現象だ。データドリフトは、AIモデルが当初学習したデータと本番環境で実際に利用しているデータの統計的分布が変わることで、AIモデルの出力が意図しない内容にずれていく現象である。

こうしたドリフトを検知するためにモニタリングするわけだが今後、企業の営みや提供する製品/サービスの各所でAIシステムが使用されていくなかで、その挙動や出力の全てを人が常時監視することは現実的ではない。『AIのリスクをどのように特定するのか(後編)【第3回】』で解説したように、リスク評価とモニタリングの位置付けを整理しつつ、矛盾や非効率さのない取り組みにしたい。AIシステムのリスクに応じて何を監視すべきか、そもそも継続的な監視が必要なAIシステムなのかなどを見定めるのがよいだろう。

利用するAIシステムに合わせてモニタリングの方法を選択する

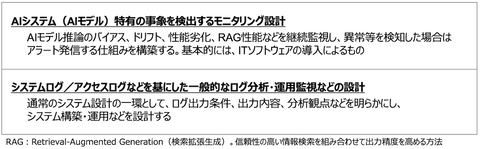

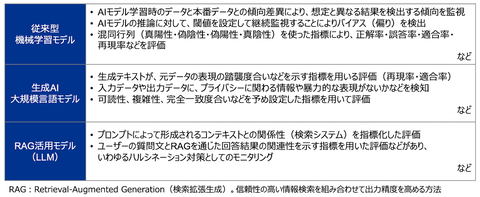

モニタリングを実施する際は、AIシステム構築の初期段階でモニタリングの方針などを検討すべきだろう。AIシステムのユースケースに応じたカテゴリー(リスク分類)によって一定の条件に合致すれば、モニタリング方法を具体化する、厳格化するといった対応が考えられる(図1)。

例えば、人の健康や安全に関わるAIシステムや、人の評価やプロファイリングなど人権侵害の可能性のあるAIシステムは、設計段階でモニタリング内容の社内承認を得てから実装するなど、組織内の基準や手続きを明らかにする必要がある(図2)。

個々のAIシステムのモニタリング内容は、リスク評価の結果により、リスク対応の一部として設計することが合理的である。構築するAIシステムやAIモデルの種類・特性によって、必要なモニタリングの内容は自ずと導出されるはずだ。AIシステム(AIモデル)に特有のモニタリングもあれば、一般的なITシステムのログ分析・運用監視として実施できることもあるため、適切な組み合わせの検討が望まれる。