- Column

- 学校では学べないデジタル時代のデータ分析法

ビッグデータの分析は客観的から主観的へ、ベイズ推定が注目される理由【第3回】

統計学では、正規分布の左右の“端”に入ったサンプルは“偶然の産物”とみられ、棄却され捨てられてきた。左右の端に入らない平均値周辺のデータが重要だとして採択される。これを「優位性検定」と呼び、客観性が高いと言われてきた。

ところが最近は、左右の端に入った内容が、ビジネスでも社会生活でも大きな影響を及ぼし始めている。加えて“全体”が従来と比較にならないほど不安定になっている。ここでいう不安定とは、量が刻々と増え、常に変化し、形式もバラバラということだ。

つまり、量が増える=Volume(ボリューム:量)、変化する=Velocity(ベロシティ:速度)、形式が多彩=Variety(バライエティ)と、ビッグデータの“3V”の要件を満たしている。これにValue(バリュー:価値)を付加するためには、統計とは違う考えが求められる。要は「結果」が分からず「原因」から試行錯誤で導きだす、確率などによる『順問題』である。

GoogleやMicrosoftなどが積極採用する「ベイズ推定」の研究者

逆問題・順問題を問わず、問題を解くには、どう解くかという手法である「アルゴリズム」と、問題を数式に置き換える「モデル化」が必要になる。ビッグデータが増え続ける今のデジタル時代に適応したアルゴリズムの1つがベイズ推定だ。

ベイズ推定は、英国で18世紀初頭に生まれた牧師であり数学者のトーマス・ベイズ氏が考えた「ベイズの定理」に基づいている。サンプル数が少なくても新しいデータで修正できるのが特徴だ。米Amazon.comはネットショッピングやクレーム処理に利用している。ほかにも、AI(人工知能)における機械学習(Machine Learning)、自動運転、スマートフォンの音声解析など多くのビジネスに適用されている。

米Microsoftの創業者であるビル・ゲーツ氏は2001年に『21世紀のMicrosoftの戦力はベイズのテクノロジーだ』と言っていた。その影響があってかMicrosoftやGoogleなどでは、ベイズ推定の研究者を積極的に採用してきた。

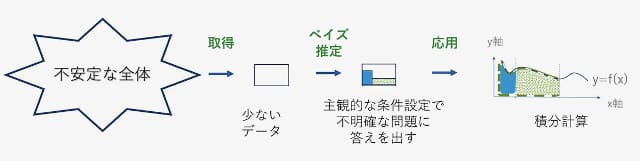

ベイズ推定を簡単に説明すれば、主観的な考えで条件を設定し、不安定な全体から抽出した安定した小さなデータ群に対し、専門家が条件を付けながら答えを求めていく手法だ。随時データを更新し、条件設定を繰り返し、事実を補正することで“真実”に近づけていく(図3)。

ベイズ推定を使った手法には2つの段階がある。1つが“学習”する段階である。推論モデルを試行錯誤により『順問題』で構築していく。もう1つが“推論”する段階だ。学習段階で作られた推論モデルから『逆問題』で解いていく。取られたデータを推論モデルと照らし合わせる。

たとえば、自動車の衝突回避では、学習段階で演算することで、周囲の移動体を把握し現在地を確認する。その後、推論段階で制御することになる。学習段階は、より多くのコンピューター資源を使う。後述するGoogleのTPU(Tensor Processing Unit)も、第一世代は推論段階専用に限られたが、第二世代は学習と推論の両段階で使えるように進化した。