- Column

- 信頼できるAIのためのAIガバナンスの実戦的構築法

AIのリスクをどのように特定するのか(後編)【第3回】

前回は前編として、AI(人工知能)に関わるリスクの内容と、リスクが社会的に強く認識される背景などに加え、企業などの取り組みとして、AIのリスクを特定するために抑えるべきポイントなどについて解説した。今回は後編として、AIのリスク評価方法について解説する。

AI(人工知能)のリスク評価方法には、デファクトスタンダード(事実上の標準)は存在しない。その方法は、さまざまで、AIのリスク評価方法は企業などの自由裁量が基本ではある。だが一方で、毎回異なる観点や方法を採用した評価結果になることは避けたい。

今後は企業などの組織内でAI技術を用いたシステムの構築頻度、つまりAIのリスクを評価する機会も多くなることが想定される。そのための仕組みとして、評価の手順や基準、実行する役割などを確立することが望まれる。

ライフサイクルを考慮したリスク評価と対策が必要

AIのリスク評価は、AIモデルあるいはAIシステム、またはその両方を評価するものと考えるべきである。いわば「AIモデルを搭載あるいは接続したシステムの構築」が管理対象であり、そのリスクを評価する。従って、その特定からリスク評価がスタートする。

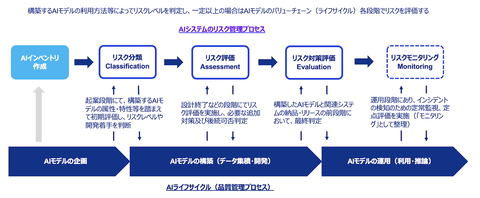

近年のAIガバナンスの主要論点の1つに、AIのライフサイクル全体にわたる各プレイヤーの役割を適切に履行し確実に実行できるようにすることが挙げられる。リスク評価や、その結果に基づく対策の実行は、ガバナンスの一部を担い、基本的には同じ考え方である。つまり、ある段階の一時的なものではなく、ライフサイクルを考慮したリスク評価と対策の実行管理が期待される。

ライフサイクルとは、AIシステムの企画から設計、開発、展開、運用などの一連の流れを意味し、その多段階の所定の時点でリスクを評価することが望ましい。

なぜリスク評価を多段階で実施する必要があるのか。利用開始後に年1回実施する、あるいは企画起案の初期段階で網羅的に評価するなどで十分ではないか、といった考えもあるだろう。リスク評価を多段階で実施する理由は、各時点で評価する目的、評価すべき/できる内容が異なるためである。

図1に一例ではあるが、リスク評価の段階を挙げる。ここでは(A)リスク分類:AIシステムの分類と同義、(B)リスク評価:実質的なリスク評価、(C)リスク対策評価:残余リスク特定と透明性確、(D)リスクモニタリング:リスクの予兆・発現などの監視、の4段階に分けている。

(A)リスク分類(Classification)

構築するAIシステムの目的や用途(ユースケース)によって、当該システム構築の企画・案件のリスクを評価する。例えば、「従業員の行動監視や評価のために使ってよいのか」「人が判断せずにAIによる判定は安全性を説明できるのか」などだ。AIが精工であるがゆえに活用の幅は広く、社会的な議論も多い。

リスク分類において許容しない領域(ユースケースの分類)を予め設定したり、厳格な開発標準や運用ルールを採用する領域など、AIシステム構築の企画・案件をいくつかのカテゴリーに振り分けたりする。リスク分類はシステム構築の初期段階の意思決定に役立ち、リスクベースアプローチの起点にもなる。

(B)リスク評価(Assessment)

システム構築の企画・起案段階では、技術的リスクを具体的に評価できない場合も多い。AIモデル構築に利用するデータの詳細や、システムがモデルに依存する場合などは、実装する機能や利用方法の詳細が決まっていないこともあるだろう。そのためリスク評価では、全体の設計が概ね完了する段階において、AIモデル構築の実際や信頼性(正確性)、安全性やサイバーセキュリティ対策など、一連の対策を検討された後に具体的に評価する。

(A)リスク分類において、ある程度厳格な対応を要するAIモデルやAIシステムを対象にするなどし、(A)でのカテゴリーと合わせて効率化の観点も検討する。