- Column

- 信頼できるAIのためのAIガバナンスの実戦的構築法

AI倫理とAIガバナンス【第8回】

前回は、AI(人工知能)セキュリティ、なかでもAIシステムに対するサイバー攻撃と対策強化の必要性について解説した。今回はAI倫理とAIガバナンスに焦点を当てて解説する。

AI(人工知能)技術の研究・開発や導入・実装には、人の倫理観や社会受容性の議論が付きまとう。全ての適用ケースではないにしてもAI倫理が問われるのは、AI技術に過剰に委ねてしまったり、人の心身に危害が及ぶ可能性があったり、AI技術に何らかの危うさを感じたりする場合である。

だがこれまで、一般社会やビジネスに幅広く適用されてきた要素技術において、ここまで倫理が問われるものがあっただろうか。近年の状況を振り返ってみる。

人間の能力に近づくほど “扱いの難しさや不安感”を助長

2010年代にディープラーニング(Deep Learning:深層学習)によるAI技術の実装が飛躍的に進むと、専門家や研究者の間でも、改めてリスクへの認識が高まり、世界中でAIの倫理観の議論が盛り上がりを見せるようになった。技術がより現実的に、より身近になる歴史的“瞬間”だったのかもしれない。

その後、2016年頃より先進国や国際機関において次々とAIの「原則」が打ち出され、ガイドラインや法律の策定が活性化していった。原則には、公平性や透明性など、AI技術に求められる複数の特性が掲げられた。

これは、AI技術が人間の知能を凌駕する転換点(シンギュラリティ)やトロッコ問題のような究極の判断を例に哲学的にリスクを考えていた時代から、AI技術のリスクを要素分解して捉え始めた時期とも言えよう。ただ「原則」は概念的であり、AI技術を開発・利用する人間の倫理観に焦点が当たる傾向にあるため「AI倫理」という言葉の登場頻度が増加した。

欧州連合(EU:European Union)は2019年に『信頼できるAIのための倫理ガイドライン』を公表した。その約2年後、欧州委員会(EC:European Commission)は同ガイドラインを基礎にした『AI規制法案』を公表し、2024年8月に発効された。AI倫理から始まり、当時のリスク認識、生成AI技術登場後の状況変化に伴う修正を経て現在に至るこれらのガイドラインや規制は、法規制の歴史的変遷を象徴する動きと言える。

では何故、AI技術では倫理に焦点が当たり、問題意識が醸し出されるのだろうか。理由の1つとしては、人の思考や判断と同等の処理を高精度な機械(システム)に実行させることが考えられる。また、必ずしも論理性や判断根拠が見えるものではないこと、結果が常に一定ではないこと、微妙に間違えてしまうことなども考えられる。

すなわち、人間の能力に近くなったがゆえに“扱いの難しさや不安感”を助長してしまうからではないだろうか。結果、「AIに処理させてよいのか」「そのような用途のAIを開発してよいのか」という疑問が生じる。企業などにとってみれば、法的には何ら問題がない場合でも、結果的に社会が受容しないとなれば風評問題につながり、責任が問われる可能性を考えなければならないのだろう。

AI倫理に関し大学教授や有識者などを交えた委員会を置く企業も

AI技術の開発・利用に先進的に取り組んでいる企業では、AI倫理の体制構築と、その運営を推進している。事業会社としては日本では先行する大手企業の一部に限定されるだろうが、公開情報などからは、AIモデルやAIシステムの開発・提供企業が積極的に推進していることがうかがえる。

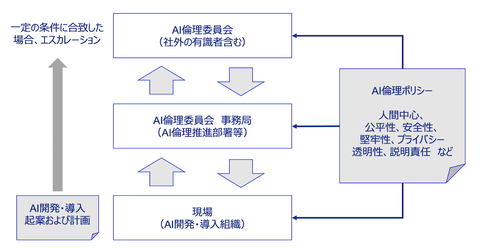

そうした企業におけるAI倫理体制は、経営層に加え、大学教授や有識者などの外部の専門家を交えたAI倫理に関する委員会組織を設置しているケースが多い(図1)。自社でAIモデル/AIシステムを開発あるいは利用する際に、一定の条件に合致した場合は当該委員会に実行可否の諮問や助言を求める運用になっているようだ。委員会設置を含む企業内の運用を支えるためのポリシーやガイドラインを策定していることも多い。

企業のポリシーやガイドラインの多くは、冒頭に触れた各国・国際機関などの諸原則や、内閣府が2019年に公表した「人間中心のAI社会原則」を参考に策定されている。実務的には、ポリシーなどを社内に公表するとともに、それに合わせたチェックリストに照らし合わせて、AI技術の開発や導入、利用の起案時にAI倫理委員会に諮るという運用方法になっているようだ。