- Column

- 大和敏彦のデジタル未来予測

AI(人工知能)のデジタル変革における可能性と活用【第3回】

「AI(Artificial Intelligence:人工知能)が人間の知能を超えるシンギュラリティが2045年に訪れる」「AIが仕事を奪う」などAIの脅威が取り沙汰されている。米Googleからは、世界最強棋士に勝った「AlphaGo」を上回る強さを持つ「AlphaGoZero」が発表された。ビジネス面でも米IBMがAIプラットフォーム「Watson」の無償提供を開始したり、米AmazonやGoogleがAIスピーカーを日本市場にも投入したりと盛んな動きが出てきている。今回はAIの現況を基に、デジタルトランスフォーメーション(DX)における可能性や課題を考えてみたい。

前回は米Amazon.comを例に、ビジネスモデルの重要性について述べた。ビジネスモデルにおいて、どのような顧客価値が提供できるのか、どう差別化していくべきかを定義し、その実現とともに強化し続けることが、ビジネスを成功させるためには不可欠だと指摘した。

そこでのデジタルテクノロジーは、顧客価値や差別化の実現に重要な役割を果たす。成功するためには、デジタルテクノロジーをどう使うかを先に考えるのではなく、自社の持つ差別化要因や技術とデジタルテクノロジーを組み合わせれば、どのような顧客価値や差別化を実現できるかを検討することが重要だ。そのためには、デジタルテクノロジーが、どのように応用可能で、その活用における課題が何であるのかを理解しなければならない。

AIは未来の技術ではなく、現状の実利を刈り取る対象に

さて昨今、目にすることがないほどに話題のAIである。ただ米調査会社のガートナーが発表した「日本におけるテクノロジーのハイブサイクル2017年」は、AIについて「“過度の期待”のピーク期」から「幻滅期」に向かおうとしているとしている。

ハイブサイクルは、技術の登場から安定期までを「黎明期」「“過度な期待”のピーク期」「幻滅期」「啓蒙活動樹」「生産性の安定期」の5つのステージに分けて説明するもの。「幻滅期」に向かおうとしている現状は、「AIが万能であり、すべての分野で仕事や生活を変える」と言われてきた過度の期待から、「現状のAIが有効に使える分野が明確になり実際の活用が広がろうとしている時期」に移ってきたと取れる。

デジタルテクノロジーの可能性や課題を考える際には、そのデジタルテクノロジーが、どのように進化してきたかを見ることが重要だ。AIの進化で言えば、図1に示す3つのテクノロジーイノベーションが大きく影響している。以下、それぞれの進化を追ってみる。

(1)機械学習(ML)/ディープラーニング(DL)の影響

機械学習(ML:Machine Learning)は、AI自身が自律的にデータに基づいて学習する方法である。ディープラーニング(DL:Deep Learning)は、その機械学習をニューラルネットワークによって行う方法だ。過去のAIは、人間によるプログラミングや“知識”のインプットが必要だった。ML/DLは、そのボトルネックを解消した。

ML/DLの仕組みや実力を機械翻訳を例にみてみたい。機械翻訳は、構文を解析し単語やフレーズに分解した後、それぞれの単語の翻訳結果をつなぎ合わせものを、翻訳ルールによって文章にする形で進んできた。この方法では、単語の登録や解析ルールの記述や見直しに膨大な時間がかかり、翻訳精度を高めていくのが難しかった。それがMLによるアプローチで精度は急速に向上した。

例えば、AIを使った機械翻訳技術を開発するロゼッタのケースでは、テーラーメード型の自動翻訳サービス「T-400(ver.1)」の翻訳精度は、従来型だと60〜80%程度なのに対し、MLを使った最新の翻訳モデルでは数種類の分野(医学、化学分野等)の英日翻訳では95%に到達したという。

ML/DLは膨大なパラメーターの集合体

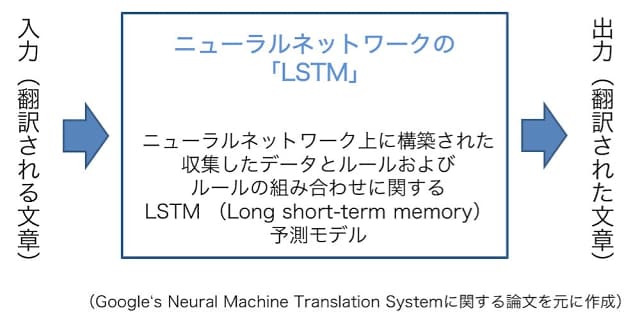

ML/DLの仕組みについて、Googleの技術論文から紐解いてみる。同社の機械翻訳システム「GNMT(Google Neural Machine Translation system)」は、ニューラルネットワークの一種である「LSTM(Long short-term memory)」を使っている(図2)。LSTMは、次の単語を予測するなど時系列でのモデルを作成するのに適している。

GNMTは、8つのエンコーダーと8つのデコーダレイヤーを備えた深いLSTMを持つ。これにより、膨大な例文の統計的処理から必要なデータとルールを収集し、ルールの組み合わせを考慮したLSTM予測モデルを作り上げる。この予測モデルによる推論と計算を組み合わせることで、翻訳スピードを上げている。出現頻度が低い単語に関しても、ほぼ同じ意味を持つ使用頻度が高い単語や複数の単語に置き換えることで、翻訳精度の低下を回避しているからだ。

ML/DLによる自律的な学習や、ルールの理解、予測モデルの構築には膨大なデータが必要であり、統計的学習から発生する課題もある。AIの研究者で現在はGoogleの同部門の対外発信に責任を持つCharina Choi氏はインタビューで次のように述べている。

「GNMTは他の大規模なニューラルモデル同様、膨大なパラメーターの集合であり、訓練の成果が、どのような内部処理になっているのかを見通すことが難しい。(中略)何かがうまく行っていないことに気付いても、その部分を簡単には置き換えられない。訓練によって新しいシステムを作り出すことは困難を伴う作業になる」