- Column

- Digital Vortex、ディスラプトされるかディスラプトするか

国家の未来を掛けたAIイノベーション戦略(後編)【第15回】

AIによる採用選考で過去データのリスクに遭遇したAmazon

さまざまな取り組みが進む中で、残念ながら、AIの倫理的な課題に直面する具体的な事例がすでに起こりだしている。Amazonが直面した、AIによる個人データの分析やプロファイリング、スコアリングが、その一例だ。

Amazonにとって、優秀な人材を継続的に獲得することは非常に重要であろう。同社の総雇用者数は、全世界で60万人を超え、米国でも2番目に従業員数が多い大企業だ。しかし、会社の持続的な成長を支える事業へ戦略的に投資する姿勢は依然として変わらない。

AIイノベーションの一例である音声AIアシスタントデバイスの「Amazon Echo」と「Alexa」に従事する従業員数は、2016年5月時点の1000人規模から、約550日後の2017年9月には5000人体制にまで拡大。さらに約350日後の2018年11月には1万人体制にまで拡大している。今でも約2200以上の募集枠がある。

それだけ大勢の人材を採用するため、Amazonでは採用選考を自動化していた。優秀な人材を探し出すAIを使ったプログラムを2014年頃から開発し始め、応募者の履歴書を自動でプロファイリングし、適正を5段階でスコアリング評価する。AmazonのECサイトで購入した商品を我々が5つのスコアで評価するのと同じイメージだ。

しかしながら、ソフトウエア開発者や、その他の技術系職種の評価においては男性を優遇していることが判明し、AIによるプロファイリングの利用を中止した。これは、約10年間の技術系職種の採用データにおいて、女性よりも男性が多かったという事実に起因するもので、AIが統計データから「男性候補者のほうが好ましい」と判断を下していたのだ。

つまり、AIが学習する過去のデータにバイアスが掛かっていたり、差別的な要素が含まれていたりすると、AIはそれらを意識することなく、その歪みをそのまま継承してしまうという危険性があることを意味している。

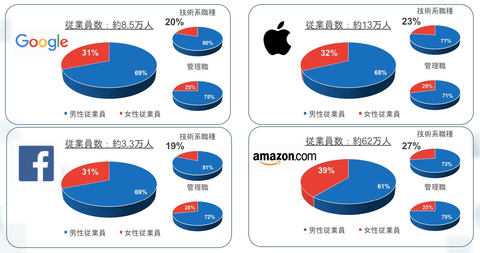

実際のAmazonは、GAFAの中でも最も女性従業員の割合が多く、ダイバーシティに積極的に取り組んでいる企業だとみられるだけに、AIプロファイリングの事件は残念な事象と言わざるを得ない(図2)。同社従業員における女性従業員の割合は、全従業員の約39%、技術系職種では約27%に上っている。

もちろんAmazonは、男女を公平に選考するようにプログラムを修正した。だが、差別的な選考要素が皆無になったかどうかを確実に保証することは、かなり困難だったと思われる。AmazonのようなAIイノベーションの先駆者であっても、AIのアルゴリズムに公平性を持たせたり、AIがなぜそのような判断を下したかを説明したりすることは、なかなか容易ではないはずだ。

社会はAIのプロファイリングやスコアリングを利活用する方向に間違いなく進んでいる。そのため、米カリフォルニア州では、AIによるプロファイリングの結果を個人情報に含める「カリフォルニア州消費者プライバシー法」を2018年6月に制定した。欧州のGDPRでも、AIによるプロファイリングなど自動処理のみに基づいて採用や融資に関わる様な重要な決定が下されないように言及している。